Was Google mit den Pixel-Smartphones und der Pixel Kamera App bei einem einzelnen Sensor bisher zeigt ist schon bemerkenswert. Was man aber auch jetzt schon mit bewegten Bildern machen kann, ist auf einem anderen Level.

Zwei, drei oder vier Kameras auf der Rückseite sind heutzutage bei Smartphones schon keine Ungewöhnlichkeit mehr. Ein Hauptsensor und eine zusätzliche Kamera, die dafür da ist, das eigentliche Bild mit Informationen zu füllen, wo sich Tiefenunterschiede finden lassen, um etwa im Portraitmodus der Kamera das Objekt künstlich vom Hintergrund freizustellen findet man schon in Budget-Smartphones um die 200€. Trotzdem haben auch die aktuellen Pixel-Geräte von Google weiterhin nur einen Sensor und mit dem erreicht man dank ausgefeilter Algorithmen und machine learning fast immer bessere Ergebnisse, als die Konkurrenz (wenn auch noch immer nicht vergleichbar mit der Fokusebene einer Spiegelreflex- oder spiegellosen Kamera mit entsprechendem Objektiv).

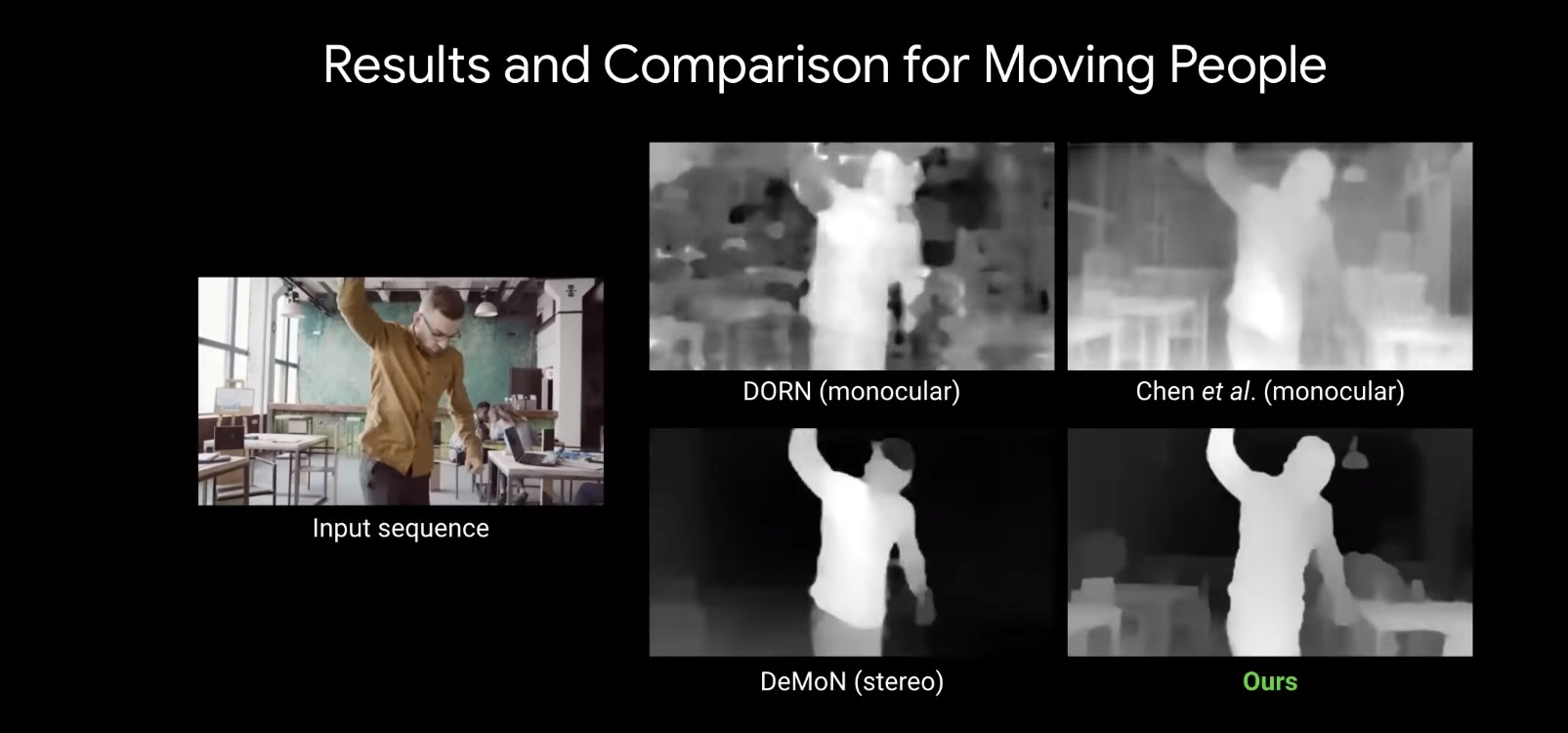

Jetzt hat Google aber in einem Blogpost den nächsten Schritt dieser Technologie gezeigt, der diese Akgorithmen auch auf Videoinhalte anwenden kann und aus der Erkennung von Personen und Objekten, sowie der Unterschiede zwischen den einzelnen Frames Tiefenunterschiede erkennen kann und deutlich Personen und Objekte vom Hintergrund trennt.

Hierfür hat man einen cleveren Input für die neuronalen Netzwerke, die die Bilder analysiert haben, gewählt: die Mannequin Challenge. Videos, bei denen Personen völlig still stehen und sich nur die Kamera durch die Umgebung bewegt und so der Eindruck einer eingefrorenen Szene geschaffen wird. Der eine oder andere erinnert sich vielleicht noch 2016… Hierauf hat Google seine Algorithmen angesetzt und diese die Videoinhalte analysieren und ermitteln lassen, wobei es sich um Personen und wobei um die allgemeine Umgebung und Hintergründe handelte:

Das Ergebnis ist dabei – genau wie bei den einzelnen Kameras der Pixel-Smartphones und deren Portraits – ziemlich beeindruckend und kommt wieder sehr nahe an das ran, was man mit „echten“ Kameras erschaffen kann, wie dieser kurze Clip hier besonders eindrücklich zeigt:

Wenn man jetzt schon so weit ist, dass man die Technik im eigenen Blog zeigt, halte ich es für nicht unwahrscheinlich, dass Google dieses Feature (zumindest erst einmal exklusiv) für die neuen Pixel-Smartphones der vierten Generation in die Google Kamera bringen könnte. Mit einem solchen Feature würde man die jetzt schon beste Kamera in einem Smartphone noch einmal auf ein neues Level heben und die direkte Konkurrenz durch Apple, Huawei und Samsung in Sachen Kamera ein ganzes Stück hinter sich lassen.