Wir sind uns wohl einig, dass das Internet voll von verpixelten und niedrig auflösenden Bildern ist. Es gibt auch eine Reihe von Argumenten, weshalb man selber keine Bilder in Originalgröße irgendwo hochlädt: begrenzter Webspace, Ladezeiten, Belastung von Datenverbindungen… Häufig geht man zugunsten u.A. dieser Punkte den Kompromiss ein, die Bilder kleiner zu skalieren und damit für Vergrößerungen quasi unbrauchbar zu machen.

Bis jetzt.

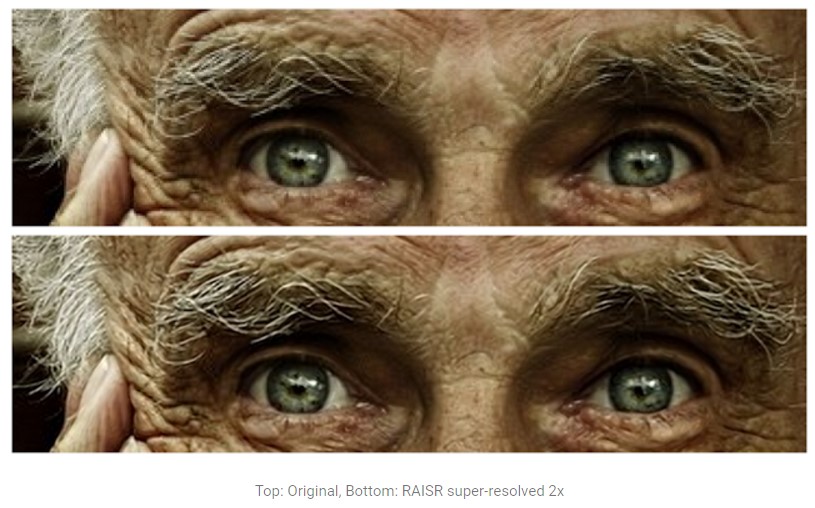

Google hat eine Technik entwickelt, die durch Algorithmen lernt, wie ein Bild von „pixelig“ zurück zu „schön“ skaliert werden kann. Das ganze heißt RAISR (Rapid and Accurate Image Super-Resolution). Hierfür wurden niedrig auflösende und hochauflösende Varianten der selben Bilder analysiert und eine Technik entwickelt, die beim Skalieren zusätzliche Pixel für das Bild errechnet, die eben nicht zu einem Weichzeichner-Effekt führen. Wobei ihr wohl besser beraten seid, euch den Original-Beitrag durchzulesen, wenn ihr die Details wissen wollt. Einfach gezeichnet arbeitet RAISR so:

Google legt noch Beispielfotos bei, die mittels RAISR hochskaliert wurden und während das erste der beiden Bilder schon sehr detailliert wirkt, wirkt der Pferdekopf dann bei 3-facher Skalierung etwas sehr arg überschärft und lässt Kontraste vermissen. Aber hey: auch mit der tollsten Technik kann man kein Blei in Gold verwandeln.

Und wofür das ganze?

Das ist das Spannende! Rein theoretisch könnten diese Algorithmen in der Zukunft in Endgeräten selber eingesetzt werden. Damit könnte man den Datentraffic noch einmal verkleinern, weil weniger hochauflösende Bilder zur Verfügung gestellt werden müssten, sondern auf dem Endgerät hochskaliert würden.

Praktischere Anwendung könnte diese Technik aber bei Kartierungen, etwa für Google Maps finden, um teils sehr niedrig auflösende Areale nach zu bessern. Ich persönlich würde mir diese Technik als Plugin für meine Bildbearbeitung wünschen. ;)

Sollte Google RAISR aber in irgendeiner Form für alle verfügbar machen, dann höchstwahrscheinlich zuerst in Google Fotos.