Dass Google die eigenen Dienste gerne selber lernen lässt, ist kein Geheimnis. Für verschiedene Funktionen innerhalb unterschiedlicher Apps und Dienste nutzt man machine learning, um diese immer weiter zu verbessern und füttert diese dafür mit Unmengen von Daten. Da kann es schon einmal passieren, dass eines der Systeme etwas lernt, was vielleicht so nicht geplant war. So zuletzt geschehen bei Google Tastatur App Gboard.

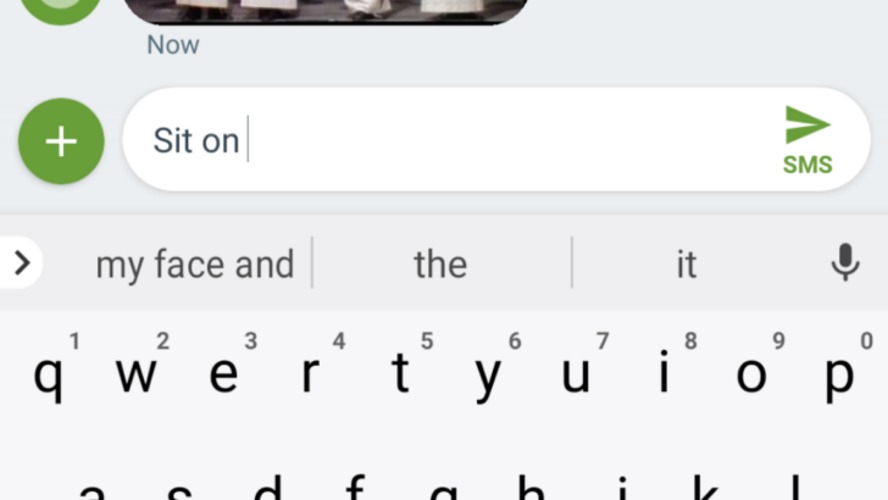

So viel vor wenigen Tagen einem Twitter-User auf, dass die App bei der Eingabe von „sit on“ den Vervollständigungsvorschlag „on my face“ machte. Und das ganze ist reproduzierbar und sorgte zumindest in den Staaten für einiges Aufsehen – irgendwie verständlich im sonst so prüden land of the free.

I was SMSing our babysitter with the default Android SMS app; I typed "Hey! Are you free to sit" and autocomplete came up with "on my face." Needless to say, I have never entered that string into my Android device. (This is not a joke)

— Cory Doctorow (@pluralistic@mamot.fr) (@doctorow) July 27, 2018

Tatsächlich haben sich auf den Tweet diverse Nutzer gemeldet und das Phänomen bestätigt und eigene Theorien geäußert, warum diese Vorschläge kommen und teil Zustimmung und Unverständnis über die Aufregung um dieses Thema kundgetan. Der besorgte Vater, der selber eine Idee geäußert, warum es zu diesem automatischen Vorschlag kommt: es liegt an Tinder und dem ganzen Sexting!

I'm wondering if this is a weird epiphenomenon of the general popularity of Tinder and sexting more generally – the inference engines are being trained on a bunch of mature-audience-only chats

— Cory Doctorow (@pluralistic@mamot.fr) (@doctorow) July 27, 2018

Zwischenzeitlich hat sich Google selber zu Wort gemeldet und mitgeteilt, dass man das Verhalten der App prüfen und korrigieren wird, um den (unangemessenen) Vorschlag nicht erneut anzuzeigen. Was die meisten wohl als amüsante Fehlinterpretation der Software von „üblicher Konversation“ verstehen würden, kann ein Unternehmen leider nicht als solche abtun und stehen lassen.

Gboard is designed to avoid such predictions in its generic models, but human language is complex, and as with any sort of system that filters sensitive phrases, sometimes inappropriate suggestions make it through into the machine learning models. When we learn of an inappropriate suggestion we work quickly to remove it.

Natürlich hat auch jeder Nutzer die Möglichkeit, automatische Vorschläge einfach aus der App zu löschen, indem man den Textbaustein bei längerem Drücken in einen Mülleimer ziehen kann – so erscheint dieser nicht mehr und auch diese Erkenntnisse fließen automatisch in die weitere Verfeinerung der Tastatur App ein. Aber ein Aufschrei ist da heutzutage wohl einfach angebrachter.

Fun fact: wenn man die Wortvorschläge weiter ausführt, wird aus allem zusammen „Hey, are you free to sit on my face and then we can talk about it later“ … also ich schmunzel über so etwas. Aber ich bin auch kein leicht zu empörender amerikanischer Vater.

Quelle: androidpolice, buzzfeednew